什麼是《歐盟人工智慧法案》

《人工智慧法案條例》(EU)2024/1689制定了人工智慧的統一規則,於2024年8月1日生效。的自願承諾和遵守《人工智慧法案》並在法定期限之前開始實施其規則。 EWC 參與了 AI Pact 研討會主題選擇的協商,並就進一步的活動提出了建議,特別是讓作家、藝術家和表演者參與 AI Pact 交流。

2024 年7 月22 日,歐盟委員會根據《歐盟人工智慧法案》(簡稱《歐盟人工智慧法案》)公佈了《人工智慧協議》承諾草案,並就與起草相關的進一步研討會選擇的主題進行了直至2024 年8 月18 日的諮詢。

EWC 在諮詢中做出了貢獻,引用:

從受 GPAI 和生成資訊學負面影響的核心群體之一的角度來看,我們代表圖書領域 50 個作家和翻譯家組織,代表 32 個歐盟和非歐盟國家的 220,000 名圖書作品個人作者,要求確認以下事項:

目前,人工智慧協議的目標集中在人工智慧開發人員、部署人員和提供者(包括人工智慧)的工作流程和利益。技術手段上。 《人工智慧法案》的實施需要對整個人工智慧生態系統的整體看法:

(a) 任何所謂「數據」的來源-個人,但包括最前沿的作家、作者、藝術家和表演者; (b) 受版權保護作品的收藏者-語料庫建構者、集合策展人; (c) (G)人工智慧產品或基於人工智慧的決策的消費者和被動用戶:公眾。

此外,有必要開發一個功能齊全的技術系統,使輸入和輸出都可追溯。還需要與人工智慧開發人員溝通,機器可讀的浮水印可以輕鬆刪除,並且 GAI 輸出需要人類可讀的標籤。這對於實現充分知情的決策和接受以及避免未來(和發生)的薪酬欺詐至關重要。

至關重要的是,《人工智慧公約》有助於建立端到端的責任鏈,讓所有相關方始終了解情況並依法行事。

最後,非常重要的是,人工智慧開發人員認識到CDSM 指令第4 條(以及第3 條及其對研究機構和商業GPAI 開發商之間私人合作關係的影響)的設計極具爭議性,以至於商業模式絕不能建立在一種片面解釋之上,即文本和資料探勘與 GPAI 和 GenAI 開發相同。授權和尊重所有作品原創者的決定與理解智慧財產權法一樣,都是人工智慧素養的一部分。

完整的 EWC 貢獻:AI Pact EWC 貢獻 240816

禁止的應用程式

新規定禁止某些威脅公民權利的人工智慧應用,包括基於敏感特徵的生物辨識分類系統,以及從網路或閉路電視錄影中無針對性地抓取臉部影像以建立臉部辨識資料庫。工作場所和學校中的情緒識別、社會評分、預測性警務(僅基於對一個人進行分析或評估其特徵時)以及操縱人類行為或利用人們的弱點的人工智慧也將被禁止。

執法豁免

原則上禁止執法部門使用生物特徵識別系統 (RBI),除非是詳盡列出和狹隘定義的情況。 「即時」RBI 只有在滿足嚴格保障措施的情況下才能部署,例如其使用在時間和地理範圍上受到限制,並受到事先特定的司法或行政授權。例如,此類用途可能包括有針對性地搜尋失蹤人員或防止恐怖攻擊。事後使用此類系統(「遠端 RBI 後」)被認為是高風險用例,需要與刑事犯罪相關的司法授權。

高風險系統的義務

對於其他高風險人工智慧系統,也預見了明確的義務(因為它們對健康、安全、基本權利、環境、民主和法治具有重大潛在危害)。高風險人工智慧用途的例子包括關鍵基礎設施、教育和職業培訓、就業、基本私人和公共服務(例如醫療保健、銀行業)、執法、移民和邊境管理、司法和民主進程中的某些系統(例如影響選舉) 。此類系統必須評估和降低風險、維護使用日誌、透明且準確,並確保人工監督。公民將有權提交有關人工智慧系統的投訴,並有權獲得有關影響其權利的高風險人工智慧系統決策的解釋。

透明度要求

通用人工智慧 (GPAI) 系統及其所基於的 GPAI 模型必須滿足某些透明度要求,包括遵守歐盟版權法和發布用於培訓的內容的詳細摘要。可能帶來系統性風險的更強大的 GPAI 模型將面臨額外的要求,包括執行模型評估、評估和減輕系統性風險以及報告事件。

此外,人造或操縱的圖像、音訊或視訊內容(「深度偽造品」)需要明確標記。

支持創新和中小企業的措施

必須在國家層級建立監管沙箱和現實世界測試,並向中小企業和新創公司開放,以便在創新人工智慧推出市場之前開發和培訓創新人工智慧。

歐盟人工智慧法案

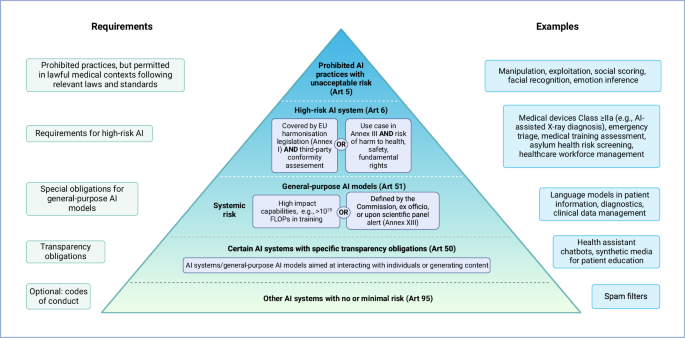

歐盟新的人工智慧法於 8 月 1 日生效。人工智慧系統對人們的健康、安全或人權構成的風險越大,它必須滿足的要求就越強。

該法案包含一份禁止的高風險系統清單。該清單包括使用潛意識技術來操縱個人決策的人工智慧系統。它還包括執法機構使用的不受限制的現實面部識別系統,類似於中國目前使用的系統。

其他人工智慧系統,例如政府當局或教育和醫療保健中使用的人工智慧系統,也被認為是高風險的。儘管這些行為並未被禁止,但它們必須遵守許多要求。

例如,這些系統必須有自己的風險管理計劃,接受品質數據培訓,滿足準確性、穩健性和網路安全要求,並確保一定程度的人工監督。

風險較低的人工智慧系統,例如各種聊天機器人,只需遵守某些透明度要求。例如,必須告訴個人他們正在與人工智慧機器人而不是真人進行互動。人工智慧生成的圖像和文字也需要包含它們是由人工智慧而不是人類生成的解釋。

指定的歐盟和國家當局將監控歐盟市場使用的人工智慧系統是否符合這些要求,並對違規行為處以罰款。

《人工智慧法案》義務的時間表是怎樣的?

在我們關於人工智慧法案的新系列的這一集中,我們技術和創新小組的高級研究員 Rosemarie Blake 和 Ciara Anderson 討論了義務應用的時間表以及人工智慧價值鏈上的不同參與者。

]

]

其他國家也紛紛效仿

歐盟並不是唯一採取行動遏制人工智慧革命的國家。

- 加拿大也在討論人工智慧和數據法案。與歐盟法律一樣,這將根據各種人工智慧系統的風險制定規則。

- 美國政府最近提出了一系列針對各領域不同人工智慧系統的不同法律,而不是單一法律。

- 澳洲可以學習並發揮領導作用。在澳大利亞,人們對人工智慧深感擔憂,並正在採取措施對新技術設置必要的護欄。隨後成立了一個人工智慧專家小組,目前正在製定第一個人工智慧立法提案。 ,在考慮如何監管多樣化的人工智慧技術時,歐盟和其他國家的監管是一個很好的開始。

歐洲人工智慧辦公室

描述來自https://digital-strategy.ec.europa.eu/en/policies/ai-office

「在機構層面,人工智慧辦公室與由成員國代表組成的歐洲人工智慧委員會以及委員會的歐洲演算法透明度中心(ECAT)密切合作。

獨立專家科學小組確保與科學界的緊密聯繫。諮詢論壇匯集了更多技術專業知識,代表了利害關係人的均衡選擇,包括工業界、新創公司和中小企業、學術界、智庫和民間社會。人工智慧辦公室還可以與個人專家和組織合作。它還將為人工智慧模型和系統(包括通用人工智慧)提供者的合作創建論壇,並為開源社群創建類似的論壇,以分享最佳實踐並為行為準則和實踐準則的製定做出貢獻。

人工智慧辦公室也負責監督《人工智慧公約》,該公約允許企業與委員會和其他利害關係人互動,例如分享最佳實踐和加入活動。這項合作在《人工智慧法案》生效之前就已經開始,將使企業能夠提前規劃並為《人工智慧法案》的全面實施做好準備。所有這些都將成為歐盟委員會倡議的歐洲人工智慧聯盟的一部分,旨在就人工智慧建立開放的政策對話。

人工智慧協調計劃規劃了歐盟內部促進值得信賴的人工智慧開發和應用的進一步舉措。

]

]

世界各地的政府都在努力解決如何最好地管理人工智慧(AI)這頭日益難以駕馭的野獸。

這項快速發展的技術有望促進國家經濟的發展,並使完成瑣碎的任務變得更加容易。但它也帶來了嚴重的風險,例如人工智慧犯罪和欺詐、錯誤訊息和虛假訊息傳播的增加、公共監視的加強以及對本已處於弱勢群體的進一步歧視。

亞太地區人工智慧監管最新動態

-

預計印度將把人工智慧監管納入其擬議的《數位印度法案》,儘管該擬議立法的草案尚未發布。不過,據報道,一個新的人工智慧諮詢小組已經成立,其任務是(1)制定促進人工智慧創新的框架(包括透過印度特定的指導方針促進可信、公平和包容的人工智慧的發展) ( 2) 最大限度地減少人工智慧的濫用。 2024年3月,政府也發布了《關於中介機構/平台盡職調查的建議》,建議平台和中介機構確保不透過使用人工智慧軟體或演算法託管或發布非法內容,並要求平台提供者識別人工智慧生成並明確告知使用者此類輸出的錯誤性。

-

印尼通訊與資訊學部副部長於 2024 年 3 月宣布,正在準備制定人工智慧法規,目標是在 2024 年底前實施。個人資料保護、版權侵權和電子資訊的現行法律。

-

日本正處於制定人工智慧法的初步階段,即《促進負責任人工智慧基本法》。政府的目標是在 2024 年底之前敲定並提出該法案。和測試)、人工智慧模型和系統的網路安全,以及向使用者揭露人工智慧的功能和限制。該框架也建議與私營部門合作實施這些措施的具體標準。

-

馬來西亞正在為人工智慧技術的使用者、政策制定者和開發人員制定人工智慧道德準則。該準則概述了負責任人工智慧的七項原則,主要關注人工智慧演算法的透明度、透過在訓練期間包含不同的資料集來防止偏見和歧視,以及評估自動決策以識別和糾正有害結果。目前沒有跡象顯示政府正在考慮實施專門針對人工智慧的法律。

-

新加坡同樣沒有宣布製定人工智慧特定法律的計畫。然而,政府於2024 年5 月推出了生成式人工智慧的人工智慧治理模型框架,該框架就整個人工智慧供應鏈中的企業如何負責任地開發、部署和使用人工智慧技術制定了最佳實踐原則。與此相關的是,政府支持的人工智慧驗證基金會發布了人工智慧驗證,這是一個測試工具包,開發人員和所有者可以使用它根據國際公認的人工智慧治理原則來評估和基準化他們的人工智慧系統。政府最近還透露,計劃為生成式人工智慧模型開發人員和應用程式部署者引入安全指南,旨在透過鼓勵人工智慧應用程式運作方式的透明度(包括使用哪些數據、測試結果、以及人工智慧模型的任何限制)並概述了在部署之前應測試的安全性和可信度屬性。

-

韓國的人工智慧法——《人工智慧產業促進法》和《建立可信任人工智慧框架》通過最後階段的投票,目前正在接受國會審查。遵循「先允許、後監管」的原則,旨在促進國內人工智慧產業的發展,但對某些「高風險人工智慧」(對公眾健康和基本權利產生重大影響的人工智慧)提出了嚴格的通報要求。

-

台灣公佈了人工智慧法草案,名為《人工智慧基本法》。該法案草案公開徵求公眾意見直至2024年9月13日。安全標準、揭露要求和問責框架。

-

泰國一直在製定人工智慧立法草案,特別是《人工智慧促進和支援法案草案》(創建了人工智慧監管沙箱)和《使用人工智慧系統的商業運營皇家法令草案》(概述了基於風險的人工智慧方法)透過對企業使用的人工智慧類別制定不同的義務和處罰來進行監管)。與歐盟人工智慧法案中採取的方法一樣,皇家法令草案將人工智慧系統分為三類:不可接受的風險、高風險和有限風險。然而,兩項立法的進展尚不清楚,2024 年沒有重大進展報道。

-

越南的人工智慧法草案,即《數位科技產業法》,正在接受公眾諮詢,直至2024 年9 月2 日。在提高其能力的專案的公司提供財務支援。它還概述了禁止的人工智慧做法,包括使用人工智慧根據生物識別數據或社會行為對個人進行分類。如果頒布,它將適用於數位科技產業(包括資訊科技、人工智慧系統和大數據公司)營運的企業。

人工智慧是一把雙面刃

人工智慧已經在人類社會中廣泛應用。它是在 Spotify 或 Netflix 等應用程式上推薦音樂、電影和電視節目的演算法的基礎。相機可以識別機場和購物中心的人員。它越來越多地用於招聘、教育和醫療保健服務。

但人工智慧也被用於更令人不安的目的。它可以創建深度偽造圖像和視頻,促進在線詐騙,助長大規模監控並侵犯我們的隱私和人權。

例如,2021 年 11 月,澳洲資訊與隱私專員 Angelene Falk 裁定臉部辨識工具 Clearview AI 違反隱私法,從社群媒體網站上抓取人們的照片用於培訓目的。然而,今年稍早 Crikey 的一項調查發現,該公司仍在為其人工智慧資料庫收集澳洲人的照片。

此類案例凸顯了對人工智慧技術進行更好監管的迫切需求。事實上,人工智慧開發人員甚至呼籲制定法律來幫助管理人工智慧風險。

遵守歐盟醫療保健人工智慧法案

]

]

20241 年3 月13 日,歐盟(EU) 27 個成員國通過了《人工智慧法案》,為監管人工智慧(AI) 邁出了關鍵一步。 2。理事會於20225年12月發布了立場,隨後歐洲議會於20236年6月通過了其談判立場。 ,並得到了成員國的認可。

作為世界上第一個專門針對人工智慧的綜合法律框架,《人工智慧法案》旨在促進以人為本和值得信賴的人工智慧,同時保護個人的健康、安全和基本權利免受人工智慧系統的潛在有害影響(文章(藝術) 1 (1))。該法案製定了人工智慧系統投放市場、投入服務和使用的統一規則,並在《歐盟官方公報》(2024 年 7 月 12 日發布)上發布 20 天後成為所有歐盟成員國具有約束力的法律,無論現有的人工智慧國家法律和準則如何(第1 (2a) 條、第113 條)。該法規的大部分內容將在 24 個月內生效,而禁令部分,即禁止被認為構成不可接受風險的人工智慧應用程序,將在 6 個月內生效(第 113 (a-c) 條)。

就目前的形式而言,《人工智慧法案》不僅在內部市場,而且在域外市場都有深遠的影響,因為它適用於歐盟市場上人工智慧系統的所有供應商,無論其建立或位於何處(第2 條) (1a);請參閱表 1) 中提供者、部署者和 AI 系統的定義。此外,如果產生的輸出在歐盟內使用,則《人工智慧法案》適用於第三國人工智慧系統的提供者和部署者(第 2 條(1c)款)。然而,《人工智慧法案》中沒有定義“輸出”,而且範例也很模糊,例如“[…] 可以影響物理或虛擬環境的預測、內容、建議或決策[…]”(第3條(1) 款) 。這表明,任何人工智慧產品,如果其輸出可以在聯盟中接收,則無論提供者或部署者的意圖或位置如何,都可能受到人工智慧法案的約束。最後,《人工智慧法案》也適用於「[……]在聯盟內建立或位於[……]的人工智慧系統部署者」(第 2 (1b) 條)。因此,歐盟境內人工智慧系統的部署者,即使其模型並非面向歐盟市場,也必須遵守人工智慧法案的規定。

表 1 歐盟人工智慧法案中人工智慧系統、提供者、部署者以及 GPAI 模型和系統的定義 全尺寸表

對於醫療保健領域,《人工智慧法案》尤其重要,因為其他現有的協調立法,例如醫療器材法規(MDR),對歐盟市場上具有預期醫療目的的產品進行監管,將其分為低風險I 類(例如,繃帶)到高風險III 類(例如,植入式起搏器))或體外診斷醫療器械法規(IVDR;監管歐盟市場上具有預期醫療目的的體外診斷設備,將其歸類為A 類(低風險) ,例如實驗室儀器)到D類(高風險,例如用於檢測伊波拉等高傳染性病原體的產品)),沒有明確涵蓋醫療人工智慧應用。此外,並非所有可在醫療保健領域採用的人工智慧應用都一定屬於MDR或IVDR的範圍,例如ChatGPT2,3等通用大語言模型(LLM)。

鑑於該法規對市場的深遠影響,醫療人工智慧領域的所有利益相關者,包括開發商、提供者、患者和從業者,都可以從理解其複雜的定義、義務和要求中受益。了解該框架將有助於明確該法規涵蓋哪些模型以及必須遵循的義務,確保人工智慧安全、負責任地實施,防止潛在危害,並最終推動醫療人工智慧的創新。在本評論中,我們著眼於醫療保健行業,探討了《人工智慧法案》最重要的方面,並提供了相關章節的易於理解的參考資料。

線上諮詢

與我們合作,馬上展開全新的創作里程碑

- 📅 立即預約,30 秒完成!

- 🎯 與創辦人 1 對 1 交流,獲得專屬建議! 🎯 與創辦人 1 對 1 交流!